| |

|

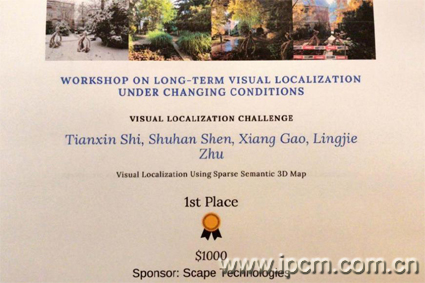

中科院自动化所机器人视觉团队获CVPR2019视觉定位竞赛冠军(附图)(2019-6-18)

日前,在美国长滩举办的计算机视觉顶级会议CVPR

2019上,中科院自动化所模式识别国家重点实验室机器人视觉课题组申抒含副研究员带领的团队获得了本年度“大时间跨度视觉定位竞赛”(Long-Term

Visual Localization Challenge)的冠军。团队成员包括研究生时天欣、高翔、朱灵杰、田雨润。

视觉定位是指利用单张图片和三维场景信息,精确地估计拍摄图像的相机三维位置和三维朝向。在许多计算机视觉和机器人的应用场景中,如自动驾驶、增强/混合现实、三维重建和SLAM等,视觉定位都是其中一项十分重要的基础技术。

近年来,针对大规模室内外场景进行视觉定位的主流方法首先需要离线构建场景三维地图,之后再根据定位图像和三维地图的匹配对应关系在线计算相机位姿。这一流程的核心难点在于,由于光照、天气、季节、场景结构变化等因素影响,构图图像和定位图像可能存在显著差异,给图像匹配和位姿计算带来了巨大挑战。

机器人视觉课题组参赛团队凭借其在三维计算机视觉领域多年的研究积累,在本次竞赛中以图像检索和PnP算法为核心,利用图像高层的语义特征不随环境变化而改变的特点,将图像的高层语义信息纳入视觉定位流程中,显著克服了环境变化所带来的影响,有效提高了定位精确度。最终,团队提交的定位结果在5个评测数据集上获得4个第一,1个第二,其总分排名第一并夺得冠军。 该竞赛由来自瑞士苏黎世联邦理工学院、瑞典查尔姆斯理工大学、英国帝国理工学院等高校的多位三维计算机视觉领域知名学者联合举办,旨在提高不同场景下的大时间跨度视觉定位能力。本次竞赛吸引了来自苏黎世理工学院、东京工业大学、韩国浦项科技大学、INRIA、Google、微软等高校和企业的多个知名三维视觉团队参与。

竞赛提供的5个数据集均来自实际场景,包含近6万张用于三维地图构建图像和近8万张用于视觉定位的图像。数据集涵盖了室外定位可能遇到的各类天气、季节、光照变化,如雨、雪、雾、春夏秋冬、黄昏、黎明、正午、黑夜等,以及可能遇到的城市、郊区、停车场等区域变化。除室外场景,数据集还涵盖了室内定位可能出现的重复纹理、弱纹理、视角狭窄、动态物体遮挡等常见问题。与此同时,竞赛在定量评估的基础上,还要求参赛队伍提交相关论文以评估算法的理论创新性和可复现性。

竞赛成绩 论文链接:Tianxin

Shi, Shuhan Shen, Xiang Gao, Lingjie Zhu. Visual Localization Using Sparse

Semantic 3D Map.

|

|

工业控制计算机网站 |

|